投手対打者の対戦成績2017(5月まで)

いまいち、野球のデータを探しても見つからない。

各種データサイトがファイルで公開していたら楽なんだけどなあ。

ほしかったのが、投手対打者の対戦成績。

見た感じどこのデータサイトも扱っていないよう。

ヤフースポーツの出場成績を見れば、今年のは集められる。

プロ野球 - 2017年3月31日 巨人vs.中日 成績 - スポーツナビ

例えばこういうの。

イニングごとのバッティング成績と、

投手の対戦打者数が掲載されているので、

とりあえず対戦成績だけは集めることができる。

ただ、去年のデータ等は消えているようだ。

一球速報も試合後消えてしまう。

これを解析したら、その対戦の状況や要した球数なども

収集できるが、めんどうくさい。すこぶるめんどうくさい。

各種データサイトはこういうことをやっているんだろうか?

対戦順に並べたデータを公開してみる。

とりあえず5月までである。

matome3.txt - Google ドライブ

matome4.txt - Google ドライブ

matome5.txt - Google ドライブ

なお、よく確認してないので間違いがあるかもしれん。

(追記)

と、思ってたら、まとめてるところあるやん…

lcom.sakura.ne.jp

日記 あさひなぐ

このあいだ、あさひなぐのライブビューイングというのに行ってきました。

ぼくは特に斎藤飛鳥さんが好きなのですが、

殆ど彼女目当てで言ったような感じで、

気まぐれで券買って、

舞台そのものには正直言って期待とかしていなかったのです。

行ってから後悔ですよ、

なんで本会場の券を取ろうとすらしなかったんだろうって。

「強くなりたい」というセリフが、彼女の言葉に聞こえるんです。

角川の連載で彼女自身、

"努力って当たり前のことだと思ってるので"

とかさらっと書いていましたが、

自分の目指すところに向かっていくその姿は

やっぱり見ていて素晴らしいのです。

実際、あすかさんだけじゃなくて、

他のキャストも輝いているのです。

アイドルってすげえなあって、思うのです。

平野美宇さんも世界卓球でメダル決めたあとのインタビューで、

なんだかよくわからない受け答えをしていて、

なんなんだこの試合との落差は…

と衝撃を受けたばかりですけども、

頑張りの原動力はアイドルって、発言がありましたよね。

彼ら彼女らがこんなに頑張ってるんだから、

自分も頑張らなきゃって、

そういう連鎖がこういう人たちの周りをバチバチと引き起ってるわけですよね。

それが世の中の人にもバチバチ影響を与えていく。

アイドルってすげえなあって、思うのです。

だから安直に、僕も頑張らなきゃなあと思うんです。

思うんですけど、

今週もぐうたらしてしまいました。

進捗ございません。

(正直映画も、(七瀬さんも好きだけど)なあちゃん主演じゃなあ

とか思っちゃったりしてたんですが、映画も期待ですね!)

進捗報告 その3

前回の記事で

理想とすれば、もう少し緩やかな傾斜を描いて、 一致率を向上させていく、というのがよさそうな感じはある。 もう少し学習率の微調整を試すべきであろうか。

と書いたので、これの続きです。

学習率を小さくとって、少しずつ動かしていきます。

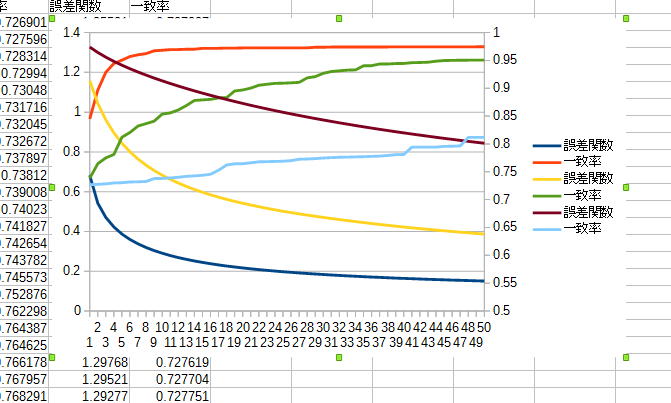

まず0.0000005で挑戦。 これまでは50回しか学習を繰り返していませんでしたが、 100回まで試してみました。 結果がこちら。

テストデータに対する誤差関数の値は、確かに下がっています。

ただ学習結果で対戦させてみると、こんな感じ。

・・・ん?

ネコかなあ!?

40をピークにして、あとは平均得点は下がっている。 誤差関数は下がっているのに、である。

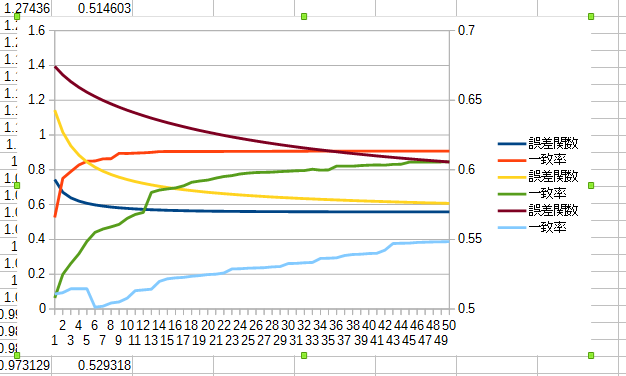

次に0.0000001で挑戦。

こちらはさらに小さいので150回やっており、順調に下がっています。

対戦の結果はこちら。

こちらは若干右肩上がりに見えるが、3.2前後のところで上げどまっている。

こちらは若干右肩上がりに見えるが、3.2前後のところで上げどまっている。

これまであまりに 「誤差関数は下がっているのに対戦成績に反映されないのはおかしい」 という点にこだわってきたが、 さすがに受け入れなくてはいけない。 つまり、これまであまりに直視してこなかったけど、 「特徴要素」をもっとうまく設定すれば、強さに反映されるんでは? いまの特徴要素ではどうあがいてもこれくらいが限度ってことなんでは?

ともかく、学習自体はうまくいっているように見える。 今度は特徴要素に注意して実験を行ってみようぞ。

進捗報告 その2

前回の、コンピュータ大貧民挑戦の続き。

進捗報告 その1 - koganie’s blog

前回、特徴要素を増やし、kou2相手に学習したところ、

対デフォルトでようやく勝ち越すことができました。

学習の仕方を変えてみたらもっと強くなるでしょうか?

学習率0.00005で10000試合分学習して、10000試合対デフォルトで対戦した結果

31151 29734 29515 29740 29860(得点。一番左が学習クライアント、それ以外はデフォルト)

で、デフォルトよりは若干強くなっているようです。

では、このまま40000試合分学習させてみましょう…の結果がこちら。

31013 29665 29806 29703 29813

見事に弱くなっています。

学習の際に、学習率に対し0.999を毎回かけて減衰させていった結果がこちら。

31169 29843 29432 29975 29581

続いて学習率を1/10して同じようにした結果。

32772 29519 29182 28990 29537

さっきより強くなっている!

では学習データを増やせば…!

31671 29645 29672 29268 29744

弱くなっている!なんでだ!

上では減衰させたが、こちらでは論文にもあるL2正則化を試してみる。

L2正則化というのは、誤差関数に

を足したもの(は正則化項の学習係数)。

をp-ノルムというようで、

ノルム - Wikipedia

すなわち

正則化 - Wikipedia

を、勾配に足していくというもの。(たぶん)

で、学習した結果がこちら。

31722 29152 29818 29986 29322

あってもなくても、大して効果はないようだ…。

どちらにせよ、テストデータに大して誤差、一致率とも向上はしているので

「過学習」をしているとは言いづらい。

実際、一致率は若干ではあるが、データ数多いほうが大きな数値をとっている。

が、現実問題としてデータ数を増やすと弱くなってしまうというのは、

過度に学習をしてしまっている、ということなのだろうか?

理想とすれば、もう少し緩やかな傾斜を描いて、

一致率を向上させていく、というのがよさそうな感じはある。

もう少し学習率の微調整を試すべきであろうか。

なんだかやる気がおきない。

もっとこう、劇的な変化してほしいが。果たして。

進捗報告 その1

以前紹介した「方策勾配を用いた教師有り学習によるコンピュータ大貧民の方策関数の学習とモンテカルロシミュレーションへの利用」

を実装したい、と臨んだ私だったが、

プログラミング能力も足らず要領も悪く、なかなか遅々として進まない。

というところで進捗報告を書きたい。

この実装をするにあたっての手順は次の通り。

1. uecda_serverを使って棋譜を採取

2. 棋譜を学習する特徴要素に変換。局面ごとに提出した手と提出しなかった手の組を作っていきテキストとしてファイル出力。

3. 2のテキストをいったん読み込み、各特徴要素ごとの分散の値を計算して保存。

4. 2と3のテキストを読みながら学習。終わったら重みベクトルを保存。

5. 4のファイルをクライアントで読み込み、対戦。

論文中に使用されている特徴要素は多々あるが、

とりあえず試しにsnowlの3パターンわけだけ実装してやってみた。

ちなみに革命中の学習ものぞいているのでここでやっているのは

「通常時で、3人以上でプレイしていて、必勝手のないとき」

の局面についてだけである。

さらに学習に使用した試合数は10000試合のみ。

(これは何度かやったが40000試合やっても大して値に変化がなかったから。学習係数をうまく調整すればうまくいくのかどうなのか)

標準クライアントでやってみると、こんな感じである。

なんとも見づらい、見やすくする配慮を全くしていないのだが、まあ気にしない。

左がテストデータに対する誤差関数の一局面あたり平均で、右が一致率。

3組もあるのは学習係数を論文の0.00005と、その1/10、さらに1/10を試しているからで、ある。

これで対デフォルト対戦をやってみると10000試合で

0.00005のとき28379 (デフォルト 30081 30502 30550 30488)

0.000005のとき28551 (デフォルト 30090 30506 30401 30452)

0.0000005のとき27760 (デフォルト 30487 30321 30853 30579)

一致率を見ると9割5分くらいは的中できているようだが、

強さを見てみるとデフォルトよりも若干下回る。

だが、とりあえず、学習はうまくいっている、と見ていいのだろうか・・・?

論文の通りであるならば、強いクライアントを教師にすれば、強い重みベクトルをゲットできるはず!

期待を胸に11回優勝クライアントGlicineから棋譜を採取し、早速学習に…。

一致率が6割ちょいくらい。まあ、論文でもそれくらいだし大丈夫でしょ。

対戦させてみると

26788 (デフォルト30474 30570 31080 31088

25833 (デフォルト30753 30929 31624 30861

21987 (デフォルト31704 32028 32079 32202

…って、弱くなってるやないかーい!

と、まあこういうことを、最近、というか結構長いことやっているわけです。

(なんども怪しいところは見直したし、もうバグはないと信じたいけど…、まあどっかにあるんだろうけど)

ちなみにkou2でも試したのですが同じようにデフォルトから学習したものよりも弱かったです。

ただ、特徴要素を増やした結果、かすかな希望が生まれました。

31229 (デフォルト29617 29502 29649 30003)

特徴要素を増やしても減らしても、一致率自体には大して変動はないのですが、

なんだかちょっと強くなっていました。

この差が一体なんなのか、よくわかっていませんが。

それにしても、対デフォルト比で大して強くなっていないのは、なんかおかしいのかなあ、です。

学習は愚直に論文中の勾配を計算して更新して、というのをc++で書いておるので、

サーバも自前、学習も自前、対戦も自前、と

プログラミング苦手なのになんでそんなバグの危険しかない道を通っているんだと、我ながら思うのですが。

もっと学習の知られざるテクニックがあるのか、

もっとミソの詰まった特徴要素があるのか、(あるいはそこにバグがあるのか)

なんだかもうわけが分からないです。

また悩みをぶちまけるかもしれないですが、

その時は少しは進捗があるといいね。

ちなみに勾配降下法っていうけど、

「W-KEYAKIZAKAの詩」にこういう詩があるんだ。

「平坦だと信じていた目の前の道、ほんの少し傾斜してる、それは希望かもしれない」

「明日に続くこの角度、上り続けていく」

誤差関数だけど、マイナスをかけないで、プラスに駆け上がっていくイメージで攻めていかないか。

おじさん、この曲好きなんです。

交流③

前回のがRLC直列回路のインピーダンスで、

同じような感じに並列回路のインピーダンスも考えることができる。

直列のインピーダンスが

だったように、並列のインピーダンスは

で、これの逆数をとればいいわけだが、面倒くさいのでやらない。

実はインピーダンスの逆数を、アドミタンスといって、計算をよく簡略化するようである。

実数部のGをコンダクタンス、虚数部のBをサセプタンスという。単位はジーメンス[S]。

ここにきてアニメの終盤を彷彿とさせる怒涛の用語攻勢である。

ただの逆数だろうに、どうしてこんな紛らわしいことをするのだろう。

上記でいえば

ここまでくるとようやく交流回路の問題が解けるようになる。

実際にはこの先三相交流というまたよくわからん代物が登場するのだが。

それはまた別のお話である。